企業數據治理之數據處理 從原始數據到決策價值的轉換引擎

在數字化轉型浪潮中,數據已成為企業最核心的資產之一。原始數據往往如同未經雕琢的璞玉,價值難以直接體現。數據處理,作為企業數據治理體系中的關鍵環節,正是將原始、雜亂、多源的數據轉化為可信、可用、可分析的高質量信息,從而支撐業務決策、驅動運營優化的核心過程。它不僅是技術操作,更是連接數據管理與數據價值實現的橋梁。

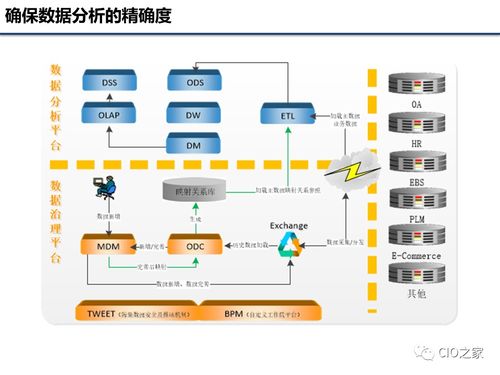

數據處理通常包含數據采集、清洗、轉換、集成、加載、存儲、計算與分析等一系列活動,其核心目標在于提升數據的質量、一致性、可用性與安全性,為后續的數據分析與應用奠定堅實基礎。

一、數據處理的核心流程

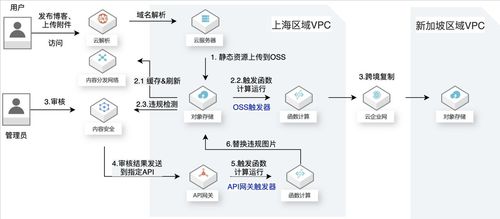

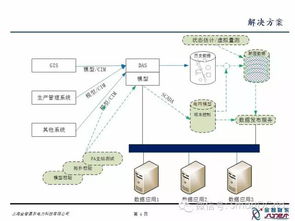

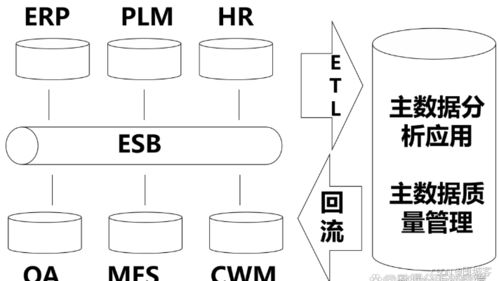

- 數據采集與獲取:從企業內部系統(如ERP、CRM、SCM)、外部數據源(如公開數據、合作伙伴數據)、物聯網設備及日志文件等渠道,通過API接口、ETL工具、流式采集等技術手段,將數據匯聚到統一的平臺或數據湖中。這是數據處理的起點,需確保數據來源的合規性與采集的完整性。

- 數據清洗與預處理:這是保障數據質量的關鍵步驟。主要任務包括:

- 處理缺失值:識別并填補、刪除或標記缺失的數據項。

- 糾正錯誤值:識別格式錯誤、邏輯矛盾或明顯異常(離群值)的數據,并進行修正或剔除。

- 標準化與規范化:統一數據格式(如日期、貨幣)、度量單位、命名規范等,消除不一致性。

- 去重:識別并消除重復的記錄,確保數據的唯一性。

- 數據轉換與集成:將來自不同源、不同結構的數據進行整合,形成統一、一致的視圖。

- 轉換:根據業務規則對數據進行計算、衍生(如生成新的指標字段)、聚合或拆分。

- 集成:通過鍵值匹配、實體解析等技術,將多源數據關聯起來,形成完整的主題域數據(如“360度客戶視圖”)。

- 數據加載與存儲:將處理好的數據加載到目標存儲系統中,如數據倉庫、數據湖或數據集市。存儲策略需考慮數據的冷熱分層、存儲成本、查詢性能以及合規性要求(如數據保留期限)。

- 數據計算與分析:在存儲的基礎上,通過批處理或實時計算引擎進行進一步的聚合、統計、挖掘與建模,生成業務所需的報表、指標、標簽或預測模型,直接服務于決策支持。

二、數據處理的關鍵原則與技術考量

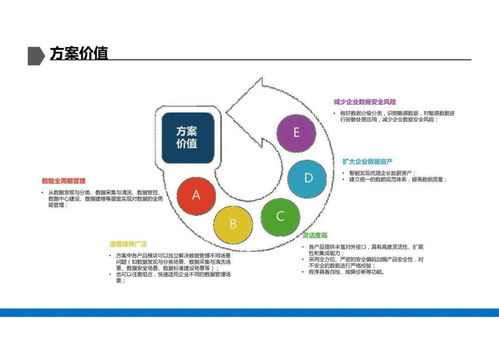

- 質量優先:建立數據質量檢核規則與監控體系,在處理的每個環節嵌入質量檢查點,確保輸出數據的準確性、完整性與時效性。

- 效率與性能:隨著數據量(Volume)、速度(Velocity)和多樣性(Variety)的激增,需選擇合適的技術架構(如Lambda架構、Kappa架構)和工具(如Apache Spark、Flink用于大數據處理),平衡處理速度與資源消耗。

- 可追溯與可審計:記錄數據處理的全鏈路血緣關系,即數據從源頭到最終消費端的完整轉換路徑。這對于問題排查、影響分析、合規審計至關重要。

- 安全與合規:在處理過程中必須嵌入數據安全控制,包括對敏感數據的識別、脫敏/加密、訪問權限控制,并確保處理流程符合GDPR、個人信息保護法等法規要求。

- 自動化與智能化:盡可能利用工作流調度工具(如Apache Airflow)實現處理任務的自動化編排與監控。探索引入AI進行智能數據清洗、異常檢測和元數據管理,提升處理效率與智能化水平。

三、數據處理在數據治理中的定位

數據處理并非孤立存在,它深度依賴于并反哺于數據治理的其他領域:

- 依賴數據標準:清洗、轉換需遵循企業統一的數據定義、編碼和模型標準。

- 落實數據質量規則:是執行數據質量檢核與提升的主要場景。

- 支撐數據安全:是實現數據分級分類、脫敏加密等安全策略的關鍵環節。

- 實現數據價值:是使數據從成本中心變為價值中心的核心轉化步驟。

卓越的數據處理能力是企業釋放數據潛能、構建數據驅動文化的基石。它要求技術與業務的深度融合,不僅需要強大的技術平臺與工具支撐,更需要明確的流程規范、嚴格的質量標準和持續的運營優化。企業應將數據處理視為一項戰略性、持續性的核心能力進行建設,確保數據在流動與加工中持續增值,最終賦能業務創新與智能決策。

如若轉載,請注明出處:http://www.svjwnk.cn/product/65.html

更新時間:2026-01-11 13:36:25